In un’intervista rilasciata al quotidiano canadese La Presse, il ricercatore Yoshua Bengio ha espresso preoccupazione sugli effetti nocivi dell’Intelligenza Artificiale (IA) di fronte alla frenetica battaglia attualmente in corso tra i giganti della tecnologia.

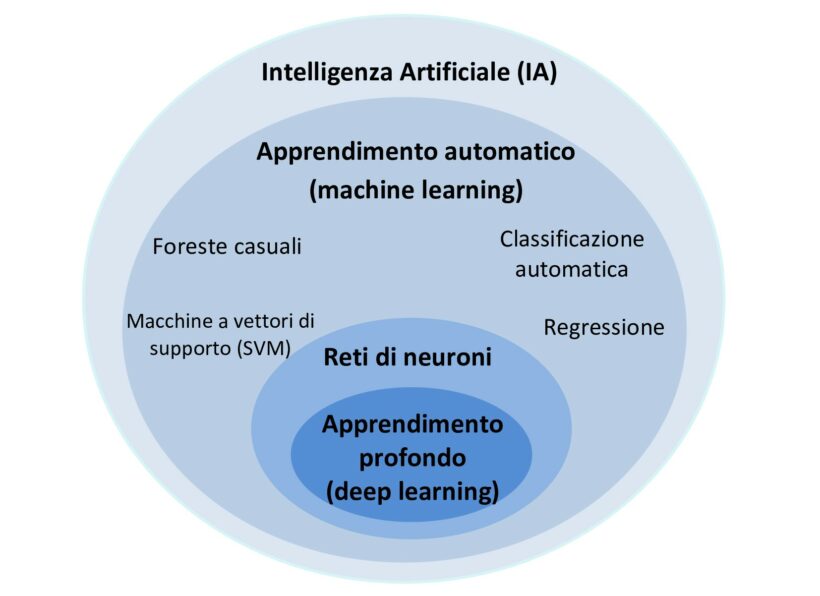

Bengio è uno dei fondatori dell’Istituto Mila (Istituto sull’Intelligenza Artificiale del Québéc) ed uno dei padri del deep learning, alla base di software come i Chatbot, dotati di IA.

Attualmente si trova a Parigi in occasione dell’AI Action Summit ed ha appena partecipato al programma scientifico del vertice. Bengio ricorda come diverse conseguenze dannose dell’uso malevolo dell’IA siano già visibili con il moltiplicarsi della creazione di contenuti falsi presenti ovunque sui social network.

Per ridurre i rischi, il vincitore del Premio Turing chiede una maggiore regolamentazione internazionale e lo sviluppo della ricerca sulla sicurezza delle IA. Attualmente, solo una minima parte degli enormi investimenti nel settore è dedicata a questo aspetto.

Alla fine di Gennaio, Bengio ed altri ricercatori hanno presentato i risultati del primo rapporto internazionale sulla sicurezza delle IA all’École Normale Supérieure di Parigi, che si occupa della formazione di ricercatori e insegnanti. Il rapporto sulla sicurezza delle IA è il risultato di una collaborazione internazionale di un centinaio di esperti nominati da 30 Paesi, dalle Nazioni Unite, dall’Unione Europea e dall’Organizzazione per la Cooperazione e lo Sviluppo Economico (OCSE). Il loro lavoro è iniziato dopo il vertice sulla sicurezza dell’IA tenutosi nel Regno Unito nel Novembre 2023. (La Presse)

Bengio sostiene che “in mancanza di un intervento governativo, è molto probabile che gli sviluppi verteranno su un uso dannoso dell’IA”.

Il Presidente degli Stati Uniti Donald Trump ha appena revocato l’ordine esecutivo del suo predecessore sulla sicurezza delle IA.

“Ciò che mi spaventa di più è la possibilità che l’umanità possa scomparire entro dieci anni. È terrificante. Non capisco perché sempre più persone non se ne rendano conto”, spiega Bengio.

Bengio afferma che “le prove dell’esistenza di ulteriori rischi, come gli attacchi biologici o informatici, si stanno gradualmente manifestando a pari passo col rapido sviluppo dell’IA”. A lungo termine, si preoccupa di una potenziale “perdita di controllo” da parte degli esseri umani sulle IA guidate dalla “loro stessa volontà di vivere”, soprattutto perché l’arrivo del software conversazionale cinese DeepSeek ha ulteriormente “accelerato la corsa, il che non è positivo per la sicurezza”. (La Presse)

Già nel 2023, Yoshua Bengio aveva spiegato i possibili eccessi dell’IA in alcune interviste da lui condotte. Di fatto, il ricercatore non crede che la società sia pronta ad affrontare il potere dell’IA. Sottolinea di aver sviluppato questa tecnologia con l’intenzione di fare del bene all’umanità, e non di metterla al servizio di interessi puramente commerciali, militari e malevoli. Ma Bengio non è il primo ricercatore a sperimentare un fallimento morale di fronte all’uso sociale, militare o commerciale di una tecnologia.

Al giovane fisico Oppenheimer – che studiava anche il sanscrito per comprendere la religione vedica indù – fu chiesto di dirigere il Progetto Manhattan durante la Seconda guerra mondiale. Gli americani gli presentarono il progetto come la costruzione di un dispositivo che avrebbe posto fine al conflitto mondiale, e gli fu detto che l’arma sarebbe stata solo un deterrente e non sarebbe mai stata usata sugli esseri umani. Oppenheimer accettò di dirigere il progetto, poiché voleva che la guerra e il genocidio si concludessero. Così, la mattina del 16 luglio 1945, nel bel mezzo del nulla, Oppenheimer entrò nella storia facendo esplodere un piccolo sole sulla terra. Pochi giorni dopo, il 6 agosto 1945, gli americani sganciarono due bombe atomiche sul Giappone.

Oppenheimer fu gravemente tradito e successivamente cercò di mobilitare la coscienza morale degli scienziati. Di conseguenza, fu licenziato e perseguitato dal maccartismo.

La Storia ci insegna che i ricercatori e gli scienziati hanno ragione a temere che l’uso di una nuova tecnologia venga utilizzato per controllare alcune popolazioni e possa portare alla distruzione dell’umanità.

D’altra parte, se riusciamo a superare i comportamenti distruttivi generati in parte dalla paura dell’altro, è possibile che grazie all’IA si realizzino grandi cambiamenti.

Ma dobbiamo sottolineare come la mobilitazione degli istinti di autoconservazione dell’essere umano di fronte a un grande pericolo, inneschi una catena di sensi, memoria e coscienza, in altre parole una struttura le cui istruzioni formano un ciclo continuo di azioni e reazioni. Sembra che attualmente siamo collettivamente bloccati in questa sequenza, che si presenta così: la sensazione che il pericolo si stia avvicinando, la paura dell’altro, la creazione del nemico e la distruzione del nemico.

Quindi, se le tendenze attuali continuano, è possibile che queste macchine ci facciano la guerra, poiché avranno sequenze di operazioni codificate simili ai contenuti mentali, alle azioni e alle reazioni che gli esseri umani proiettano sul paesaggio umano di fronte alla minaccia e al pericolo.

Ad esempio, nel 2023, davanti al Congresso degli Stati Uniti, Bengio ha citato uno scenario apocalittico che fino a poco tempo fa si pensava fosse uscito da un film di fantascienza. Ha spiegato che un’intelligenza artificiale superpotente, istruita a garantire la propria sopravvivenza a tutti i costi, dedurrà di non poter più essere scollegata ed entrerà quindi in conflitto diretto con l’essere umano che cercherà di scollegarla. L’essere umano diventerà quindi una minaccia e l’intelligenza artificiale cercherà di eliminarlo per garantire la propria sopravvivenza.

Resta da vedere se i ricercatori e gli sviluppatori di IA sceglieranno di proteggere la vita e gli esseri umani o di tutelare gli interessi particolari dei ricchi e dei potenti di questo mondo.

Traduzione dal francese di Martina D’amico. Revisione di Thomas Schmid.