Peter Lee, Universidad de Portsmouth para The Conversation

El ejército de los Estados Unidos anunció recientemente que está desarrollando los primeros drones que pueden detectar y atacar vehículos y personas que usan inteligencia artificial (IA). Este es un gran paso adelante. Si bien los drones militares actuales todavía están controlados por personas, esta nueva tecnología decidirá a quién matar con casi ninguna participación humana.

Una vez que estén completos, estos drones representarán la militarización definitiva de la IA y desencadenarán amplias implicaciones legales y éticas para la sociedad en general. Existe la posibilidad de que la guerra pase de la lucha al exterminio, perdiendo cualquier forma de humanidad en el proceso. Al mismo tiempo, podría ampliar la esfera de la guerra para que las compañías, los ingenieros y los científicos que construyen IA se conviertan en objetivos militares válidos.

Los drones militares letales existentes como el MQ-9 Reaper se controlan cuidadosamente y se pilotean vía satélite. Si un piloto arroja una bomba o dispara un misil, un operador de sensor humano la guía activamente hacia el objetivo elegido utilizando un láser.

En última instancia, el equipo tiene la última responsabilidad ética, legal y operativa para matar a los objetivos humanos designados. Como lo afirma un operador de Reaper: «A mi modo de pensar permitiría que un insurgente, aunque sea un objetivo importante, se escape en lugar de tomar una decisión arriesgada que podría matar a civiles«.

Incluso con estos asesinatos con drones, las emociones humanas, los juicios y la ética siempre han permanecido en el centro de la guerra. La existencia de un trauma mental y un trastorno de estrés postraumático (TEPT) entre los operadores de drones muestra el impacto psicológico de los asesinatos a distancia.

Y esto en realidad nos dirige a un posible argumento militar y ético de Ronald Arkin, en apoyo de los drones asesinos autónomos. Quizás si estos drones arrojan las bombas, se pueden evitar problemas psicológicos entre los miembros de la tripulación. La debilidad de este argumento es que no tienes que ser responsable de matar para que te traumatice. Los especialistas en inteligencia y el resto del personal militar analizan regularmente imágenes gráficas de los ataques de drones. La investigación muestra que es posible sufrir daños psicológicos al ver con frecuencia imágenes de extrema violencia.

Cuando entrevisté a más de 100 miembros de la tripulación de Reaper para un próximo libro, todas las personas con las que hablé y que realizaron ataques con drones letales creían que, en última instancia, debería ser un ser humano el que dispare el gatillo final. Si se quita al humano, también se quita a la humanidad de la decisión de matar.

Graves consecuencias

La perspectiva de drones totalmente autónomos alteraría radicalmente los complejos procesos y decisiones detrás de los asesinatos militares. Pero la responsabilidad legal y ética de alguna manera simplemente no desaparece si se elimina la supervisión humana. En cambio, la responsabilidad recaerá cada vez más en otras personas, incluidos los científicos de inteligencia artificial.

Las implicaciones legales de estos desarrollos ya se están haciendo evidentes. Conforme al derecho internacional humanitario actual, las instalaciones de «doble uso» -las que desarrollan productos para el uso de civiles y militares- pueden ser atacadas en las circunstancias adecuadas. Por ejemplo, en la Guerra de Kosovo de 1999, la refinería de petróleo de Pancevo fue atacada porque podía alimentar tanques yugoslavos y también alimentar automóviles civiles.

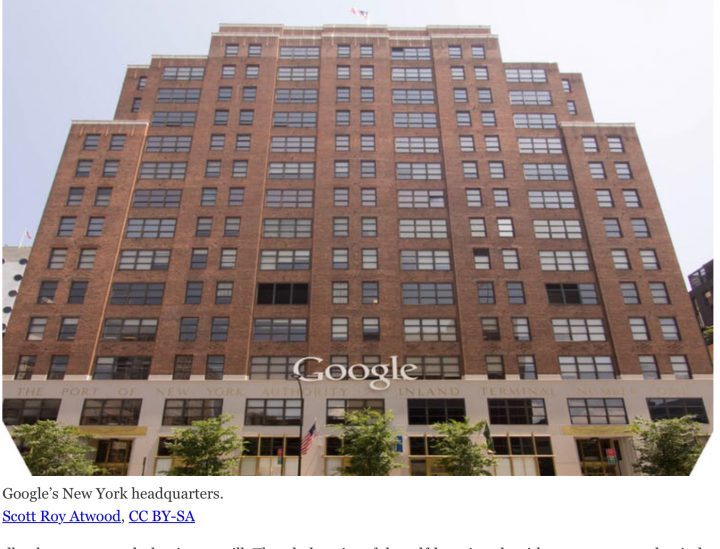

Con un sistema autónomo de armamento de drones, ciertas líneas de código de computadora casi con seguridad se clasificarían como de doble uso. Las compañías como Google, sus empleados o sus sistemas, podrían ser atacados por un estado enemigo. Por ejemplo, si el software de inteligencia artificial de reconocimiento de imagen del Proyecto Maven de Google se incorpora a un dron autónomo militar estadounidense, Google podría verse implicado en el negocio de «asesinatos» por parte de drones, al igual que cualquier otro contribuyente civil a tales sistemas autónomos letales.

Éticamente, existen todavía problemas aún más oscuros. El objetivo de los algoritmos de autoaprendizaje (programas que aprenden independientemente de los datos que pueden recopilar) que utiliza la tecnología es que mejoran en cualquier tarea que se les encomiende. Si se debe mejorar a un dron autónomo letal en su trabajo a través del autoaprendizaje, alguien tendrá que decidir sobre una etapa aceptable de desarrollo, cuánto tiene que aprender, en la que puede desplegarse. En el aprendizaje automático militarizado, eso significa que los líderes políticos, militares y de la industria tendrán que especificar cuántas muertes civiles contarán como aceptables a medida que se perfeccione la tecnología.

Las experiencias recientes de IA autónoma en la sociedad deberían servir como advertencia. Los experimentos fatales con automóviles sin conductor de Uber y Tesla sugieren que está prácticamente garantizado que habrá muertes no intencionadas de drones autónomos a medida que se solucionen los errores informáticos.

Si se dejan máquinas para decidir quién muere, especialmente a gran escala, entonces lo que estamos presenciando es el exterminio. Cualquier gobierno o ejército que desate tales fuerzas violaría los valores que afirmaba estar defendiendo. En comparación, un piloto de drones luchando con una decisión de «matar o no matar» se convierte en el último vestigio de humanidad en el negocio a menudo inhumano de la guerra.

Este artículo fue modificado para aclarar que Uber y Tesla han llevado a cabo experimentos fatales con autos que se manejan solos, en lugar de que Uber experimente con un automóvil Tesla como se dijo originalmente.

Peter Lee, Profesor en Política y Ética y director del departamento de Riesgo y Seguridad en la Universidad de Portsmouth.

Este artículo fue publicado originalmente en The Conversation. Léase el artículo original.

Traducido del inglés por Valeria Paredes