Die dänische Sozialbehörde Udbetaling Danmark (UDK) läuft Gefahr, Menschen zu diskriminieren, indem sie künstliche Intelligenz (KI) zur Bekämpfung von Sozialleistungsbetrug einsetzt. Betroffen sind Menschen mit Behinderungen, Menschen mit geringem Einkommen und Menschen mit Migrations- und Fluchthintergrund. Das zeigt heute ein neuer Bericht von Amnesty International.

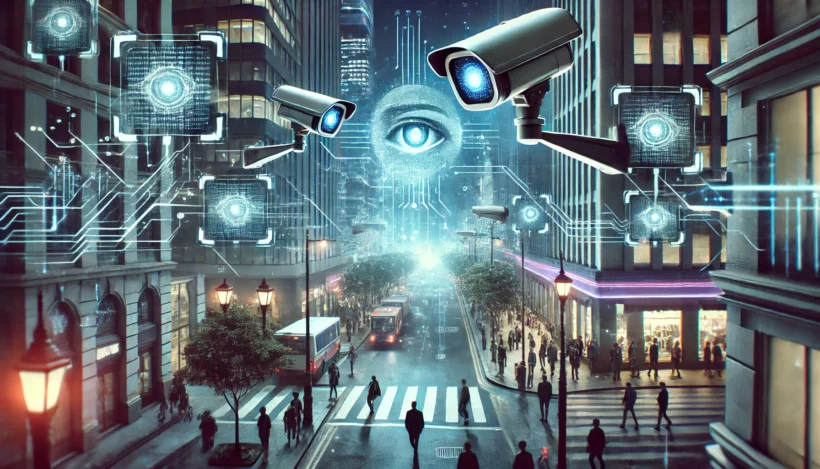

Der Bericht Coded Injustice: Surveillance and Discrimination in Denmark’s Automated Welfare State (Überwachung und Diskriminierung in Dänemarks automatisiertem Wohlfahrtsstaat) beschreibt detailliert, wie der weitreichende Einsatz von Algorithmen zur Bekämpfung von Sozialleistungsbetrug, gepaart mit Massenüberwachung, dazu geführt hat, dass Menschen unfreiwillig – oder sogar unwissentlich – ihr Recht auf Privatsphäre verwirkt haben, und eine Atmosphäre der Angst entstanden ist.

Die Art und Weise, wie das dänische automatisierte Sozialsystem funktioniert, untergräbt die Privatsphäre des Einzelnen und die Menschenwürde.

Hellen Mukiri-Smith, Forscherin für Künstliche Intelligenz und Menschenrechte bei Amnesty International

„Diese Massenüberwachung hat ein Sozialleistungssystem geschaffen, das die Gefahr birgt, dass es genau die Menschen ins Visier nimmt, die es eigentlich schützen sollte.“

BIS ZU 60 ALGORITHMEN: ÜBERWACHUNGSMASCHINE DOKUMENTIERT DAS LEBEN VON BETROFFENEN

Die UDK hat das Unternehmen Arbejdsmarkedets Tillægspension (ATP) mit der Verwaltung von Sozialleistungen und Betrugsbekämpfung beauftragt. ATP wiederum hat sich mit privaten multinationalen Unternehmen, darunter NNIT, zusammengetan, um Algorithmen zur Betrugsbekämpfung zu entwickeln, die auf die Spezifikationen von ATP zugeschnitten sind.

UDK und ATP verwenden ein System von bis zu 60 algorithmischen Modellen, die angeblich dazu dienen, Sozialleistungsbetrug zu erkennen und Personen für weitere Ermittlungen durch die dänischen Behörden zu kennzeichnen. Während der Untersuchungen erhielt Amnesty teilweise Zugang zu vier dieser Algorithmen.

Um die Algorithmen einsetzen zu können, haben die dänischen Behörden Gesetze erlassen, die eine umfassende Sammlung und Zusammenführung von personenbezogenen Daten aus öffentlichen Datenbanken von Millionen dänischer Einwohner*innen ermöglichen. Die Daten enthalten Informationen über Aufenthaltsstatus und -bewegungen, Staatsangehörigkeit, Geburtsort und familiäre Beziehungen – sensible Daten, die auch etwas über die Ethnie oder sexuelle Orientierung einer Person aussagen könnten.

„Diese weitreichende Überwachungsmaschine wird eingesetzt, um das Leben einer Person zu dokumentieren und ein Bild zu erstellen, das oft nichts mit der Realität zu tun hat. Sie verfolgt und überwacht, wo ein*e Sozialhilfeempfänger*in wohnt, arbeitet, die Reisetätigkeit, Gesundheitsdaten und sogar Verbindungen zum Ausland“, so Hellen Mukiri-Smith.

Die UDK argumentiert, dass die umfangreiche Sammlung und Zusammenführung von personenbezogenen Daten zur Aufdeckung von Sozialleistungsbetrug „rechtlich begründet“ sei. Die Untersuchungen von Amnesty International zeigen jedoch, dass die enormen Datenmengen, die gesammelt und verarbeitet werden, weder notwendig noch verhältnismäßig sind.

DISKRIMINIERENDE ALGORITHMEN BEFEUERN SYSTEM DER UNGLEICHHEIT

So setzen die dänischen Behörden zur Aufdeckung von Sozialleistungsbetrug bei Renten- und Kinderbetreuungsprogrammen den Algorithmus Really Single ein, um den Familien- oder Beziehungsstatus einer Person vorherzusagen. Zu den Parametern, die der Algorithmus verwendet, gehören „ungewöhnliche“ oder „atypische“ Lebensmuster oder Familienverhältnisse – unklar ist jedoch, wie diese aussehen können, womit willkürlichen Entscheidungen Tür und Tor geöffnet sind.

So laufen Menschen in nicht-traditionellen Lebenskonstellationen – wie Menschen mit Behinderungen, die verheiratet sind, aber aufgrund ihrer Behinderung getrennt wohnen; ältere Menschen in Beziehungen, die getrennt leben; oder Menschen, die in einem Mehrgenerationenhaushalt leben – alle Gefahr, vom Really-Single-Algorithmus ins Visier genommen und auf Sozialleistungsbetrug untersucht zu werden.

Hellen Mukiri-Smith, Forscherin für Künstliche Intelligenz und Menschenrechte bei Amnesty International