Daniela Gschweng für die Online-Zeitung INFOsperber

Frauen eher als Männer, Migranten eher als Einheimische, Arme eher als Reiche und weniger Gebildete sowieso – seit 2018 bewertet ein Algorithmus, wer im schwedischen Sozialsystem wahrscheinlich betrügen wird. Ist das gerecht? Nachvollziehbar? Begründet?

Es gibt Kritik, denn in der Realität wird selten betrogen. Die Künstliche Intelligenz scannt dennoch Hunderttausende Personen, die Sozialgelder beantragen. Tausende werden als verdächtig markiert und einem ausführlichen Profiling unterzogen. Ohne davon zu erfahren und ohne jemals etwas falsch gemacht zu haben.

Schwedische Behörden mauerten jahrelang

Die Sozialversicherungsbehörde Försäkringskassan will sich zu ihrem Vorgehen nicht in die Karten schauen lassen. Interne Quellen bezeichnen die Algorithmen als das bestgehütete Geheimnis.

Die schwedische Tageszeitung «Svenska Dagbladet» und das Investigativmedium «Lighthouse Reports» blieben jahrelang hartnäckig, um herauszufinden, wie die KI urteilt. Während drei Jahren versandte Lighthouse Reports hunderte E-Mails und stellte mehrere Anfragen auf Dateneinsicht nach dem Öffentlichkeitsgesetz. Die Behörde lehnte sie sämtlich ab. Sie weigerte sich sogar, Daten herauszugeben, die sie bereits veröffentlicht hatte.

Zwei Gerichtsverfahren und einen geleakten Datensatz später fanden die beiden Medien, dass der Predictive-Algorithmus mehrere Personengruppen diskriminiert. Die Datenanalyse offenbarte schwerwiegende Probleme wie ungleiche Behandlung von Antragstellenden und fragwürdige Betrugsvorwürfe. Dazu kommt mangelnde Transparenz und das Fehlen effektiver Beschwerdemechanismen.

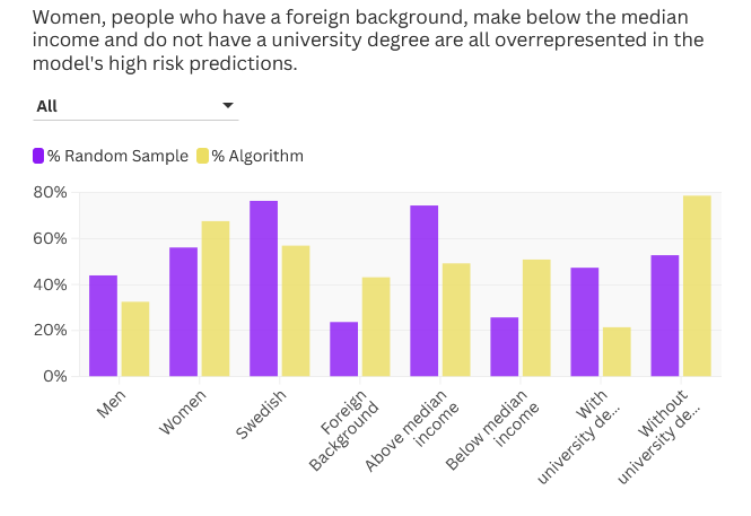

Der geleakte Datensatz enthielt Daten von mehr als 6000 Menschen, die Unterstützung beantragt hatten, weil sie sich um kranke Kinder kümmern mussten und die der Algorithmus als verdächtig ausgewählt hatte. Frauen, Menschen mit migrantischem Hintergrund, Geringverdienende und Personen ohne universitären Abschluss wurden dabei übermässig häufig verdächtigt, zu betrügen. Frauen 1,7-mal häufiger, Migranten 2,3-mal häufiger, weniger Gebildete und Geringverdienende dreimal häufiger als eine demografisch angepasste Zufallsauswahl.

Gegenüber einer Zufallsauswahl wurden Frauen, Menschen, die unter dem Medianeinkommen verdienten und solche mit Migrationshintergrund und geringerer Bildung deutlich häufiger als verdächtig ausgewählt. © Lighthouse Reports

Die Betroffenen bleiben oft ohne Unterstützung und wurden in teils invasive Untersuchungen verwickelt. Auszahlungen wurden verzögert. Amnesty International, das die beiden Medien beratend unterstützt hatte, veröffentlichte im November 2024 ebenfalls eine Stellungnahme.

Das System gleicht einer Hexenjagd

David Nolan, Amnesty International

Die Anti-Betrugs-KI sei ein typisches Beispiel dafür, dass das Recht der Menschen auf soziale Sicherheit, Gleichheit und Nichtdiskriminierung sowie auf Privatsphäre durch ein System verletzt würden, das eindeutig voreingenommen sei, sagte David Nolan, Senior Investigative Researcher bei Amnesty Tech.

Die Behörde weist Vorwürfe zurück und argumentiert, dass ein menschlicher Prüfer die endgültigen Entscheidungen treffe. Dieser habe weitreichende Kompetenzen, beschreibt die Menschenrechtsorganisation.

Er könne die Social-Media-Konten einer Person durchforsten, Daten von Institutionen wie Schulen und Banken einholen und sogar die Nachbarn einer Person befragen. Die Person, die dabei durchleuchtet wird, hat keinerlei Ahnung, dass sie von einem Algorithmus als verdächtig markiert wurde. Das System, so Nolan, gleiche einer Hexenjagd.

Bedenken wurden jahrelang ignoriert

Warnungen gab es bereits 2018, als die Kontrollbehörde ISF (Inspectorate for Social Security) darauf hinwies, dass der Algorithmus «in seiner derzeitigen Ausgestaltung nicht der Gleichbehandlung entspricht». Ein ehemaliger Datenschutzbeauftragter der schwedischen Sozialversicherungsanstalt warnte 2020, der gesamte Vorgang verstosse gegen die europäische Datenschutzverordnung. Die Behörde habe keine Rechtsgrundlage für die Erstellung von Profilen von Einzelpersonen.

Nach der kürzlich verabschiedeten europäischen Verordnung über künstliche Intelligenz (KI-Gesetz) müssten KI-Systeme zudem strenge Kriterien erfüllen, um sicherzustellen, dass sie nicht gegen Menschenrechte verstiessen. Schweden laufe Gefahr, einen Skandal loszutreten wie schon die Niederlande vor einigen Jahren. 2019 wurde dort aufgedeckt, dass tausenden Erwachsenen zu Unrecht das Kindergeld entzogen oder tausende Euro von ihnen zurückgefordert worden waren, vor allem von Ausländer:innen.

Amnesty International fordert sofortigen Stopp

Es sei schwierig festzustellen, ob das schwedische KI-System unter das KI-Gesetz falle. Zu dieser Unsicherheit trage die Verweigerungshaltung der schwedischen Behörden bei. Es gebe jedoch Hinweise darauf, dass das System das Recht auf Gleichbehandlung verletze und Menschen diskriminiere. Deshalb müsste es sofort abgestellt werden.

Bedenken äussert Amnesty auch gegenüber Künstlicher Intelligenz, die im dänischen und französischen Sozialsystem verwendet wird.