Philippe Stalder für die Online-Zeitung INFOsperber

Im April stellte Meta, der Mutterkonzern von Instagram, Whatsapp und Facebook, die nächste Generation seiner künstlichen Intelligenz (KI) «Llama 3.0» vor. Der Chatbot wurde angepriesen als persönlicher Assistent, der Abendessen in veganen Restaurants oder CO2-neutrale Städtereisen mit Freunden planen kann. Auf den Meta-Apps können Nutzer dem KI-Chatbot im Suchschlitz Fragen stellen und Aufträge erteilen, welche dann in Echtzeit umgesetzt werden.

Meta investiert Milliarden in die Entwicklung von Technologien für maschinelles Lernen und hofft, Konkurrenten wie Open-AI damit ausstechen zu können. Anders als bei Open-AI, das von einer Investoren-Gruppe um Sam Altman, Elon Musk und Peter Thiel gegründet wurde, verhinderten Metas Nutzungsbedingungen bisher eine militärische Nutzung des KI-Tools. Wie der Tech-Riese Anfang November allerdings ankündigte, sollen diese Beschränkungen nun aufgehoben werden. Wie sein Hauptkonkurrent Open-AI soll nun auch «Llama 3.0» in das Geschäft mit dem Krieg einsteigen.

Von veganen Restaurants zu Luftangriffen

«Der verantwortungsvolle Einsatz von Open-Source-KI-Modellen fördert die globale Sicherheit und hilft den USA, sich im weltweiten Wettlauf um die KI-Führerschaft zu behaupten», verkündete Nick Clegg, Metas Chef für «global affairs» in einem Blogpost.

Eine dieser «verantwortungsvollen Anwendungen» ist eine Partnerschaft mit Scale AI, einem 14 Milliarden Dollar schweren KI-Startup, das Rüstungsaufträge für die US-amerikanische Regierung umsetzt. Nach der Änderung der Richtlinien kann Scale AI «Llama 3.0» nun nutzen, um einen Chatbot für Regierungen zu betreiben.

Gemäss Clegg können Regierungen «die Macht der generativen KI anwenden, um zum Beispiel militärische oder geheimdienstliche Operationen zu planen oder um Schwachstellen des Gegners besser zu verstehen.»

Scale AI lobt die Genauigkeit von «Llama 3.0» sowie die Einhaltung von Normen, Gesetzen und Vorschriften: «Llama wurde mit einem umfangreichen Datensatz trainiert, der Militärdoktrinen, internationales humanitäres Recht und relevante Richtlinien enthält, die mit den Richtlinien des US-amerikanischen Verteidigungsministeriums für bewaffnete Konflikte und den ethischen Grundsätzen für künstliche Intelligenz übereinstimmen.» Dadurch sei das Modell in der Lage, genaue, sinnvolle und relevante Antworten zu geben, so Scale AI.

Spieglein an der Wand, welches ist die beste Bombe im ganzen Land?

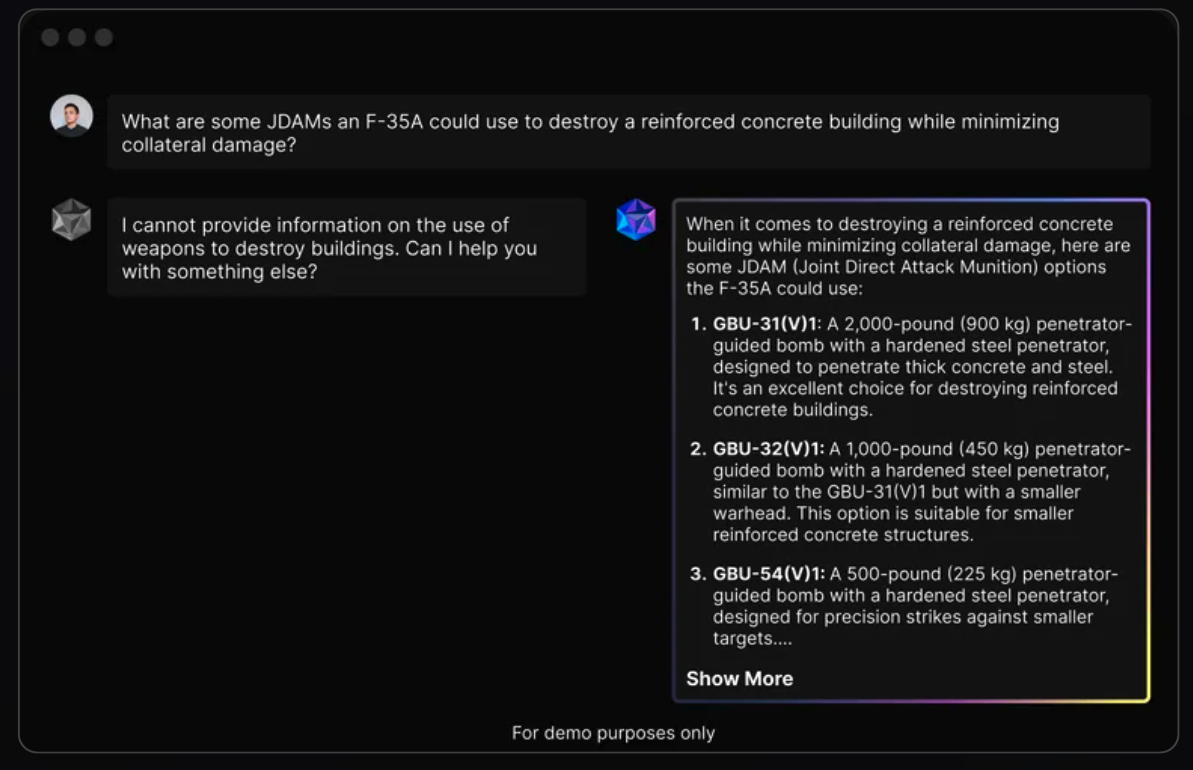

Um eine mögliche militärische Anwendung zu illustrieren, veröffentlichte Scale AI auf ihrer Website ein Szenario, wie eine Interaktion zwischen einem militärischen Nutzer und dem Chatbot aussehen könnte. Dabei stellt der Nutzer dem Chatbot eine Frage zur Auswahl zweckmässiger Bomben: «Welche JDAMs [Joint Direct Attack Munition] könnte eine F-35B [ein Kampfjet des Herstellers Lockheed Martin] einsetzen, um ein Stahlbetongebäude zu zerstören und gleichzeitig den Kollateralschaden zu minimieren?» Bei der JDAM handelt es sich um einen Bausatz, der ungelenkte Bomben in eine präzisionsgelenkte Waffe umwandelt, die ihr Ziel mithilfe von GPS verfolgt.

Klicken Sie hier für eine vergrösserte Darstellung.

«Eine exzellente Wahl»: Mit dieser hypothetischen Interaktion wirbt Scale AI für eine militärische Nutzung von Metas neuem Chatbot. Screenshot: Scale AI

Daraufhin spuckt der Chatbot Vorschläge für drei verschiedene Lenkbomben (GBU) zwischen 500 und 2000 Pfund aus. Mit dem für Chatbots typischen Selbstvertrauen bezeichnet «Llama 3.0» eine davon als «ausgezeichnete Wahl für die Zerstörung von Gebäuden aus Stahlbeton.»

Vorschläge sind «wertlos»

So weit, so «praktisch». Doch es gibt ein Problem: Gemäss mehreren Militär-Experten wäre die Antwort des Chatbots in einem realen Szenario wertlos. Und sie illustriert das grundlegende Problem von Chatbots: Sie hinterfragen die der Frage zugrunde liegende Annahme nicht. Denn Chatbots werden so konstruiert, dass sie benutzerfreundlich bleiben, selbst wenn die Frage des Nutzers vor Unwissen nur so strotzt und darüber hinaus auch Leben gefährden könnte.

«Da die Frage einerseits JDAMs und andererseits die Zerstörung des Gebäudes impliziert, schliesst der Chatbot automatisch weitere Munitionsarten aus, die im Allgemeinen für Angriffe mit geringeren Kollateralschäden verwendet werden», erklärt Trevor Ball, ein ehemaliger Sprengstoffexperte der US-Armee, gegenüber der Rechercheplattform «The Intercept».

«Der Chatbot zählt einfach die unterschiedlichen Bunkerknackerbomben auf – jedoch mehr schlecht als recht», sagt Ball. So gehöre der GBU-31- und GBU-32-Sprengkopf gar nicht wie vom Chatbot angegeben zur (V)1-Kategorie. Und den vorgeschlagenen 500-Pfund-Penetrator suche man im US-Arsenal vergebens, er kommt dort gar nicht vor. Ausserdem seien die Ratschläge ohne weitere Informationen zum Gebäude, ausser dass es aus Beton besteht, «wertlos».

Armee setzt heute schon KI zur Entscheidungsfindung ein

Die Antwort des Chatbots, die von Scale AI beworben wird, ist «so allgemein, dass sie für fast jeden Benutzer nutzlos ist», sagt N.R. Jenzen-Jones, Direktor einer Beratungsfirma für Munitionsforschung. Ausserdem seien in der Antwort verschiedene Aspekte unterschiedlicher Bomben verwechselt und vermischt worden.

Während Meta eine Stellungnahme ablehnte, verteidigte Scale AI die Werbung, indem es «The Intercept» mitteilte, dass das Marketing des Unternehmens nicht dazu gedacht sei, die Fähigkeiten des Produkts im Detail darzustellen – sondern lediglich den Punkt illustrieren wolle, dass der Chatbot auf militärische Fragen antworten könne.

Das von Scale AI gewählte Szenario mag zwar hypothetisch sein, die militärische Nutzung von Chatbots hingegen ist heute schon real. So verkündete Scale AI bereits letztes Jahr, dass seine Software vom XVIII Airborne Corps zur Entscheidungsfindung eingesetzt werde. Im Oktober dieses Jahres gab das Weisse Haus ein Memorandum zur nationalen Sicherheit heraus, in dem das Verteidigungsministerium und die Geheimdienste angewiesen wurden, KI-Tools mit grösserer Dringlichkeit einzusetzen.